Di recente, Eric Schmidt, l’ex CEO di Google, ha detto che dovremmo “staccare la spina” all’intelligenza artificiale quando inizierà a migliorarsi da sola.

Una dichiarazione forte, che riflette il timore diffuso di perdere il controllo su qualcosa che abbiamo creato noi stessi.

Chiariamo subito che non parliamo di una verità assoluta, ma di un punto di vista, benchè autorevole.

Inoltre, a dirla tutta, Schmidt ha parlato anche di molto altro ed ha inserito alcune di queste affermazioni “forti” che sono state fatte rimbalzare ovunque e molti “influencers” ci sono buttati a capofitto, si sa che il sensazionalismo su Internet “paga” in termini di visualizzazioni.

Per capire meglio cosa ha detto Eric, suggerisco di ascoltarlo in questo estratto video che abbiamo tradotto per voi da un suo speech all’università di Stanford

La solita paura del cambiamento

Mi chiedo: è meglio fermare il progresso perché ne abbiamo paura o forse dovremmo solo imparare a governarlo?

Se c’è una cosa che la storia ci insegna, è che ogni grande innovazione ha generato ansia e scetticismo.

Ricordate la rivoluzione industriale?

Si diceva che le macchine avrebbero distrutto il lavoro degli operai, lasciando tutti in miseria.

È successo? NO!!

È vero, il mondo del lavoro è cambiato, ma si sono create nuove opportunità.

Lo stesso è accaduto con l’arrivo di Internet. All’inizio, in tanti pensavano che la rete avrebbe portato caos e disinformazione.

Certo, qualche problema c’è stato, ma abbiamo saputo adattarci, regolamentare e sfruttare questa tecnologia per connetterci, informarci e creare nuove economie.

Ecco perché trovo sbagliato fermare l’intelligenza artificiale e ancora peggio pensare di “staccare la spina”, ma piuttosto capire come fare in modo che questa tecnologia rimanga uno strumento eccezionale nelle nostre mani.

L’intelligenza artificiale non è un nemico

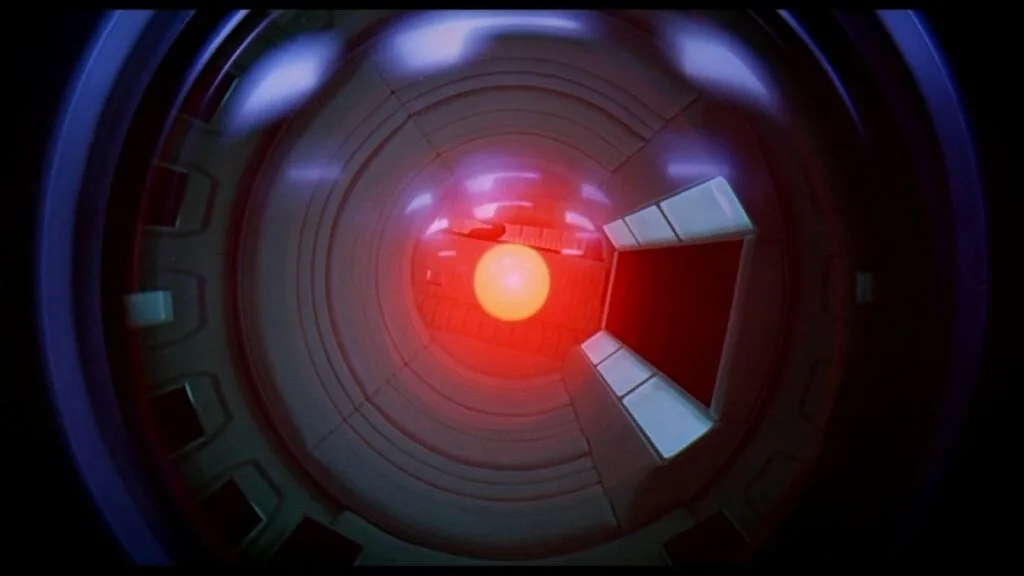

L’idea che un’IA in grado di auto-migliorarsi possa sfuggire al controllo umano è più una fantasia da film di fantascienza che una realtà imminente.

L’esempio più celebre resta forse quello di HAL9000 HAL 9000 è il supercomputer di bordo della nave spaziale Discovery nel film 2001: Odissea nello spazio di Stanley Kubrick. )

A tale proposito una curiosità: il suo nome è l’acronimo per “Heuristic ALgorithmic” (“algoritmo euristico”), ma alcuni fecero notare all’epoca che spostand le tre iniziali di una lettera si ottenesse IBM… all’epoca incontrastata dominatrice della scenza informatica… che sia stata una prima pubblicità occulta? ;-)

Clarke e Kubrick respinsero questa teoria, considerandola una semplice coincidenza. Questa fu almeno la loro posizione ufficiale, in parte anche perché furono interpellati i dirigenti di IBM riguardo alla produzione di un film che presentava un computer psicotico, oltre che sull’utilizzo del logo IBM sulla tuta spaziale in una scena del film. Clarke rivelò che, inizialmente, il supercomputer doveva chiamarsi “Athena”, ma il nome fu successivamente cambiato in “Hal”, abbreviazione del nome inglese Henry.

Tornando alla realtà, oggi, anche l’AI più avanzata è e resterà qualcosa che abbiamo creato noi, non è un’entità autonoma con una coscienza o uno scopo.

Se permettiamo a questa paura di prendere il sopravvento, rischiamo di perderci enormi opportunità. Pensate a cosa potrebbe significare un’intelligenza artificiale in grado di ottimizzarsi:

- Cure mediche avanzate: sistemi che scoprono terapie per malattie oggi incurabili, analizzando enormi quantità di dati in tempi rapidissimi.

- Sostenibilità ambientale: algoritmi capaci di aiutarci a ridurre gli sprechi energetici e a combattere il cambiamento climatico.

- Innovazione industriale: processi produttivi più efficienti, che tagliano costi e riducono l’impatto ambientale.

Tutte queste cose non accadranno da sole. Saranno il frutto del nostro impegno nel gestire l’IA, guidarla e utilizzarla con responsabilità.

Serve responsabilità, non paura

Certo, è giusto porsi delle domande, così come è necessario porsi regole chiare, controlli e trasparenza.

Nessuno dice che dobbiamo lasciare l’IA crescere senza freni, ma fermarla a priori è come rinunciare in partenza. La chiave, secondo me, è la responsabilità.

Immaginiamo un mondo in cui l’IA si auto-migliora, ma lo fa all’interno di limiti definiti:

- Norme globali che ne regolano lo sviluppo.

- Supervisione umana costante, per assicurarsi che tutto proceda nel modo giusto.

- Trasparenza totale, con sistemi aperti e monitorabili.

La tecnologia non è buona o cattiva: dipende solo da come la usiamo.

E se abbiamo creato l’IA, possiamo anche stabilire come deve comportarsi.

Fermarsi è un lusso che non possiamo permetterci

Dire di fermare l’intelligenza artificiale significa rinunciare a un futuro pieno di possibilità.

Pensiamo ai problemi globali che affrontiamo oggi: la crisi climatica, le malattie, la scarsità di risorse.

Abbiamo bisogno di soluzioni innovative, che gli esseri umani, da soli, presi dalle proprie fobie, abitudini e ideologie, non possono raggiungere o quantomeno non possono farlo in tempi acettabili: ecco dove l’IA potrebbe essere lo strumento che mancava.

Capisco chi ha paura, così come sia normale temere l’ignoto, ma fermarsi non è la risposta, MAI.

Quello che dobbiamo fare è prenderci la responsabilità di governare questa tecnologia, proprio come abbiamo fatto con altre innovazioni in passato, evitando di farsi prendere da isterismi illogici e migliorando la nostra capacità di governare i cambiamenti tecnologici, che, state pur certi, non si fermeranno.

Il futuro è nelle nostre mani, non in quelle delle macchine.

Quindi non dobbiamo “staccare la spina”, ma prendere atto che:

- una nuova era tecnologica è iniziata

- non possiamo fare nulla per fermarla o limitarla

- oggi non possiamo sapere dove ci porterà

quindi l’unica scelta saggia è anche la più semplice: dobbiamo imparare a usarla meglio…